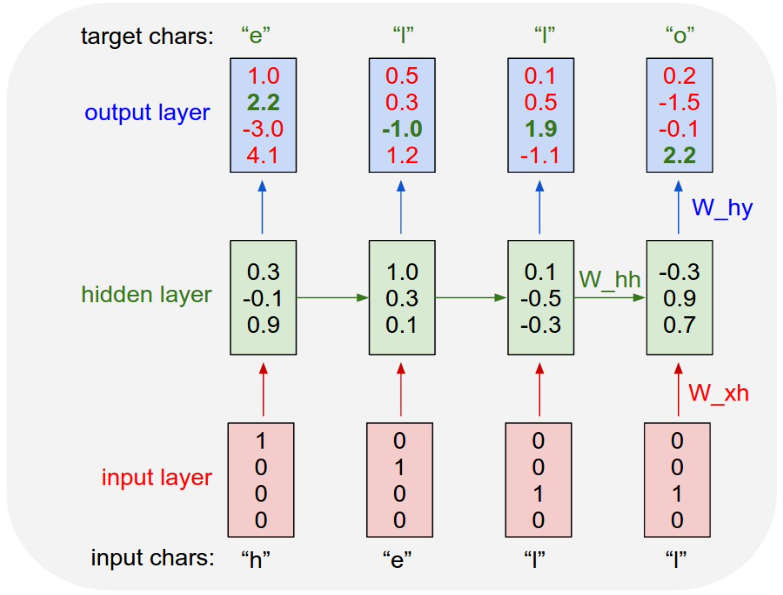

🧑🏻💻용어 정리 Character-level Language Model Auto regressive model LSTM GRU Character-level Language Modeling task 자연어 처리에서의 기본 task인 language model이라는 task에 대해서 살펴봅니다. 주어진 Example training sequence에 대해 Input Layer의 값을 Input chars에 대해서 one-hot vector로 구성합니다. 그렇다면 입력 vector를 현재 time step의 x 입력 vector로 받게 되고 그 전 time step에서 넘어오는 ht-1이라는 추가적인 입력 vector를 받아서 현재의 Hidden state vector ht를 계산하게 됩니다. 참고로, t가..