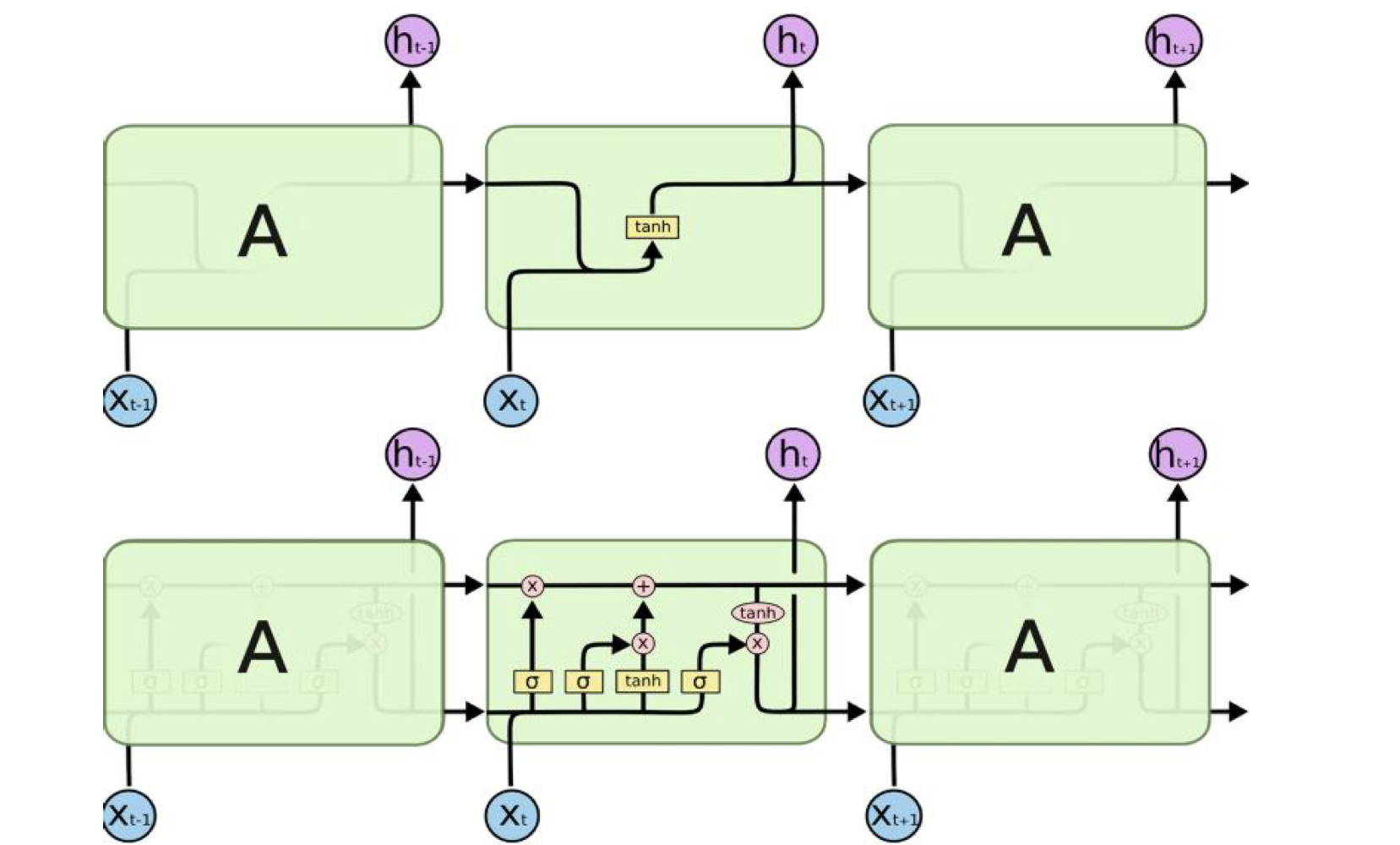

🧑🏻💻용어 정리 Neural Networks Feed-forward Backpropagation Convolutional Neural Network Recurrent Neural Network LSTM Attention Cell state forget gate input gate output gate 이전 시간까지 RNN의 여러 가지 종류에 대해 알아보았습니다. 조금 더 살펴봅시다. RNN의 단점 RNN을 쭉 연결시켜 놓고 보니, 특히 Encoder, Decoder 부분에서 확연히 들어나는 이 특징은, 너무 입력되는 문장이 길다보니, Long-Term Dependency 문제가 발생합니다. input signal의 정보를 h t에 과거에서부터 계속 모아옵니다. 그런데 과거의 더 이전 시점의 무언가가 필..