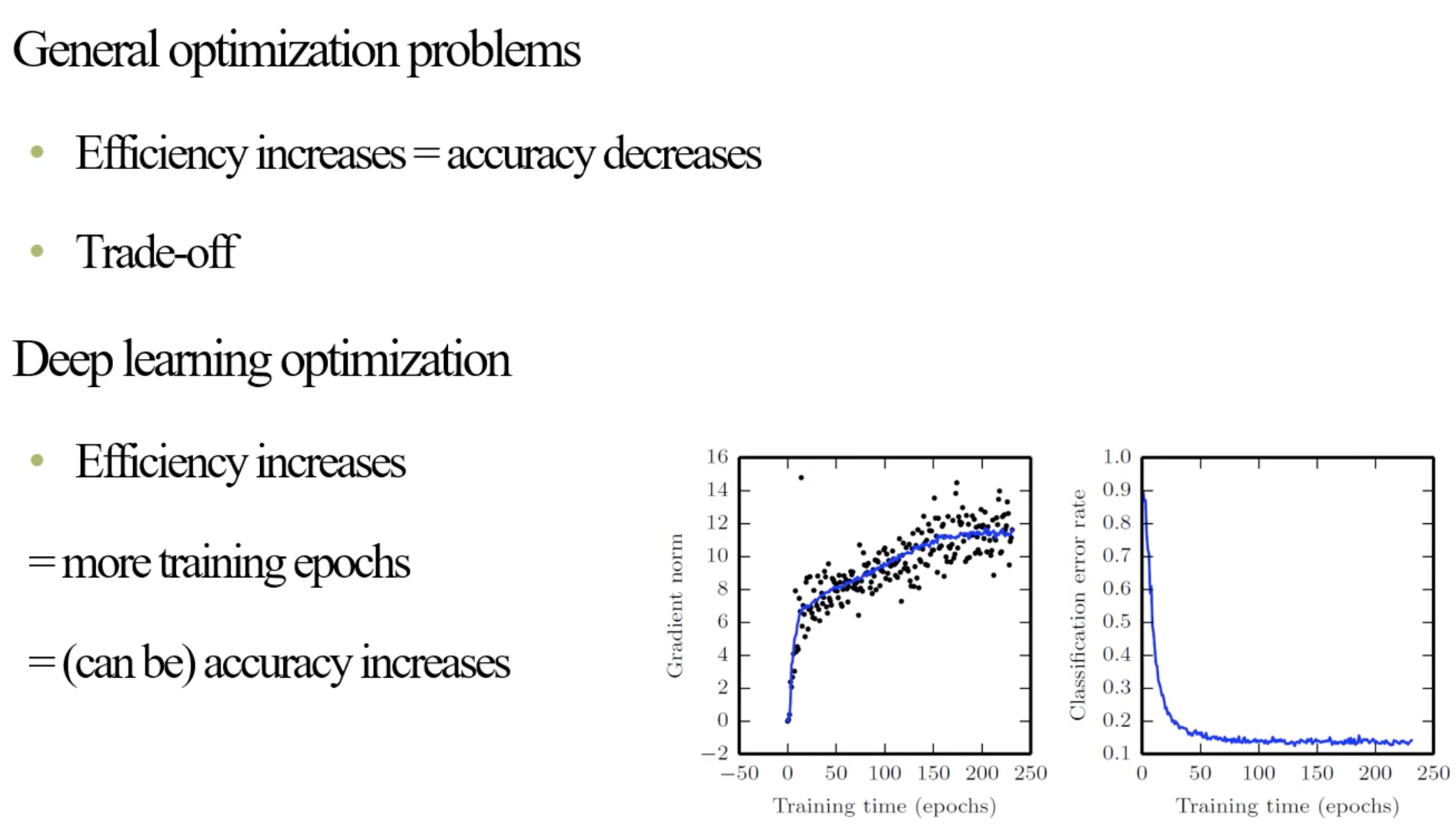

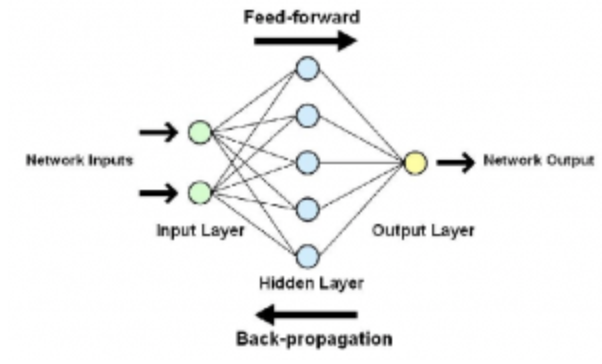

🧑🏻💻용어 정리 Neural Networks Feed-forward Backpropagation Convolutional Neural Network stride filter kernel topology MLP image multi-channel sparse connection parameter sharing 오늘부터 CNN에 대해서 배워봅시다. 지금까지는, linear separability, MLP, Feed-forward, Backpropagation, regularization, optimization 등을 살펴보았습니다. 그리고 오늘은 새로운 model CNN에 대해서 살펴봅니다. 그리고, 위와 같이 지금까지 배운 부분들이 MLP와 CNN이 다르지 않습니다. 거의 90%는 그대로 적용된다고 봐도..