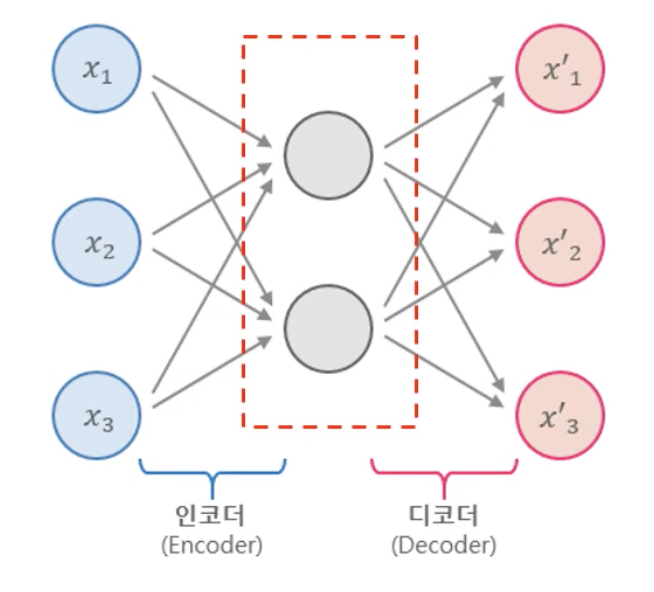

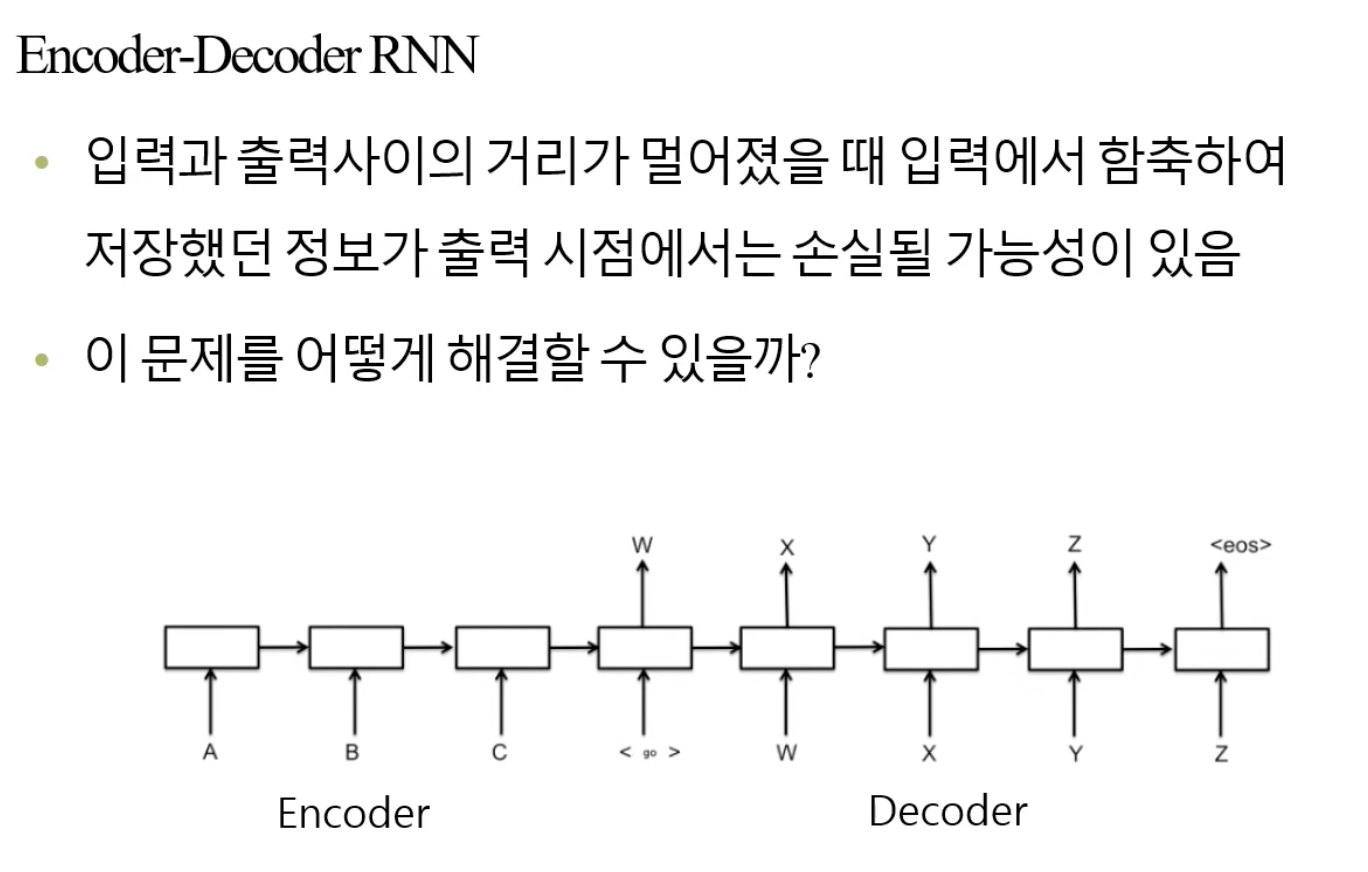

🧑🏻💻용어 정리 Deep Generative Models Generative Model Discriminative Model pre-training fine-tunning DBN VAE encoder autoencoder reparametrization trick 이번에는 Deep Generative Models이라 불리는 생성 모델에 대해 보겠습니다. Deep Generative Models 이 Generative Model은 생성 모델, '생성하는 모델'입니다. 즉, data를 생성할 수 있는 모델을 의미합니다. 우리는 평균과 분산을 가지는 확률 분포에 의해 data를 무한히 생성해낼 수 있습니다. 이것으로부터 sampling, generation 등으로 부릅니다. 만약 우리가 N(0, 1)과 같은..