🧑🏻💻 주요 정리

NLP

Word Embedding

CBOW

Represent the meaning of word

- Two basic neural network models:

- Continuous Bag of Word(CBOW) : use a window of word to predict the middle word.

- Skip-gram (SG) : use a word to predict the surrounbding ones in window.

위와 같은 차이를 보입니다.

하나씩 살펴봅시다.

CBOW (Continuous Bag of Word)

"The cat sat on floor" 이라는 문장이 있다고 합시다.

이 문장을 CBOW 방식으로 Window size = 2로 학습을 시키려고 합니다.

다음을 살펴보겠습니다.

위와 같이 가운데 단어 하나를 제외한 양쪽 두 개씩(window size만큼)의 단어를 input으로 주고 output을 가운데 단어가 되도록 학습 시킵니다.

이 형태로 다시 살펴봅시다.

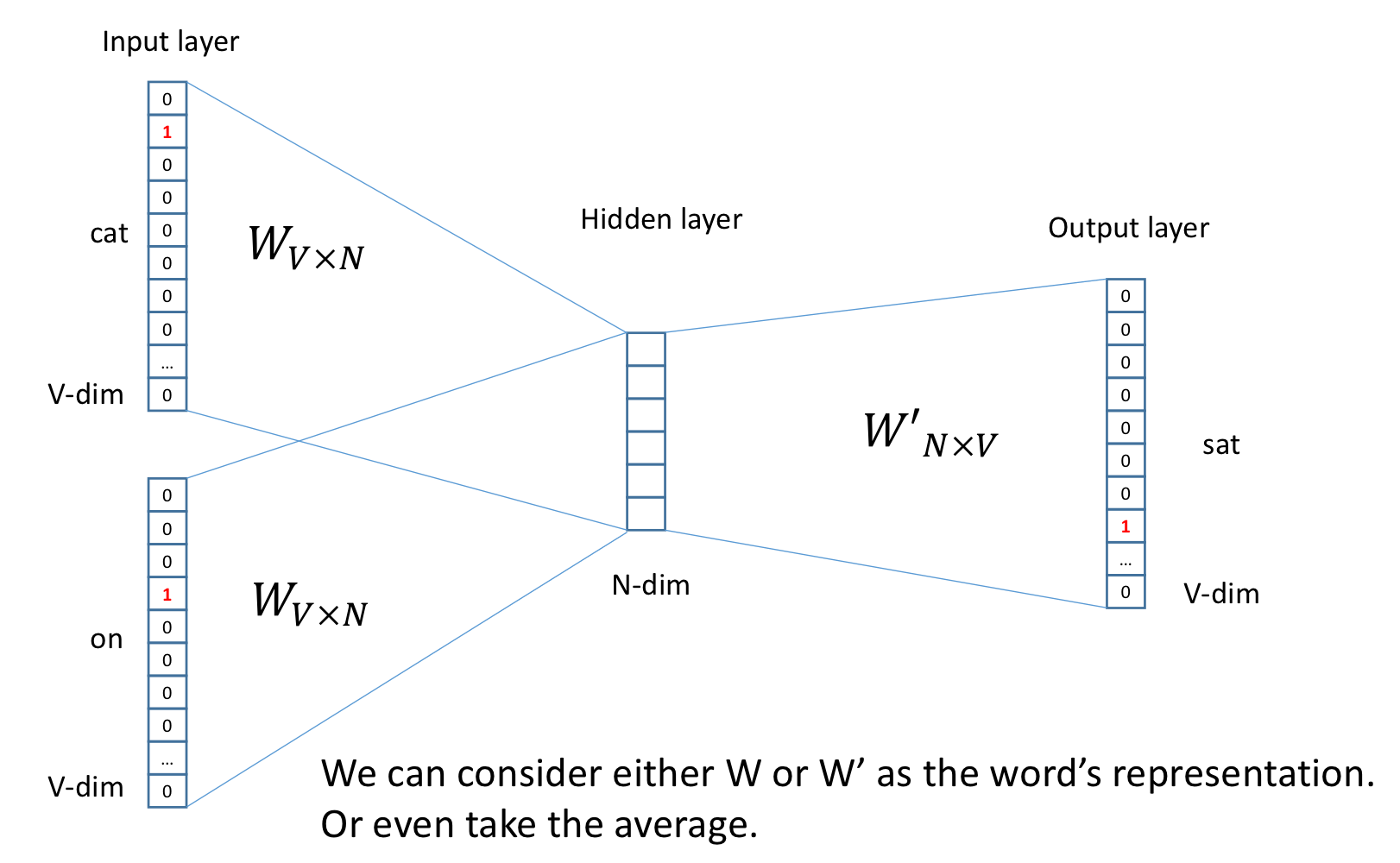

각 단어들을 one-hot encoding을 거쳐 one-hot vector로 만듭니다.

즉, 문장을 Neural Network 형태로 바꾼 것입니다.

그리고 다시,

각각의 단어들을 input에 대해서 hidden layer 연산을 하여 output layer에서 "sat"의 vector를 계산합니다.

그리고,

input의 one-hot vector를 아래와 같이, hidden layer를 거쳐서 "sat"이라는 단어의 word embedding 과정을 거칩니다.

그리고, 아래와 같이

The cat ___.

___에 들어가는 sat, eat, sit, is ,... 등의 단어는 비슷하게 학습 되어 비슷한 공간에 mapping 되는 방식입니다.

We can consider either W or W’ as the word’s representation. Or even take the average.

결국, 가운데 t 번째 인덱스의 단어를 가지고, t - 2, t - 1, t + 1, t + 2번째 인덱스의 단어들을 학습하는 형식입니다.

'Artificial Intelligence > Natural Language Processing' 카테고리의 다른 글

| [NLP] Word Embedding - Word2Vec (0) | 2023.03.27 |

|---|---|

| [NLP] Word Embedding - Skip Gram (0) | 2023.03.27 |

| [NLP] Introduction to Word Embedding (0) | 2023.03.26 |

| [NLP] Overview NLP (0) | 2023.03.21 |

| [NLP] Introduction to NLP (0) | 2023.03.21 |