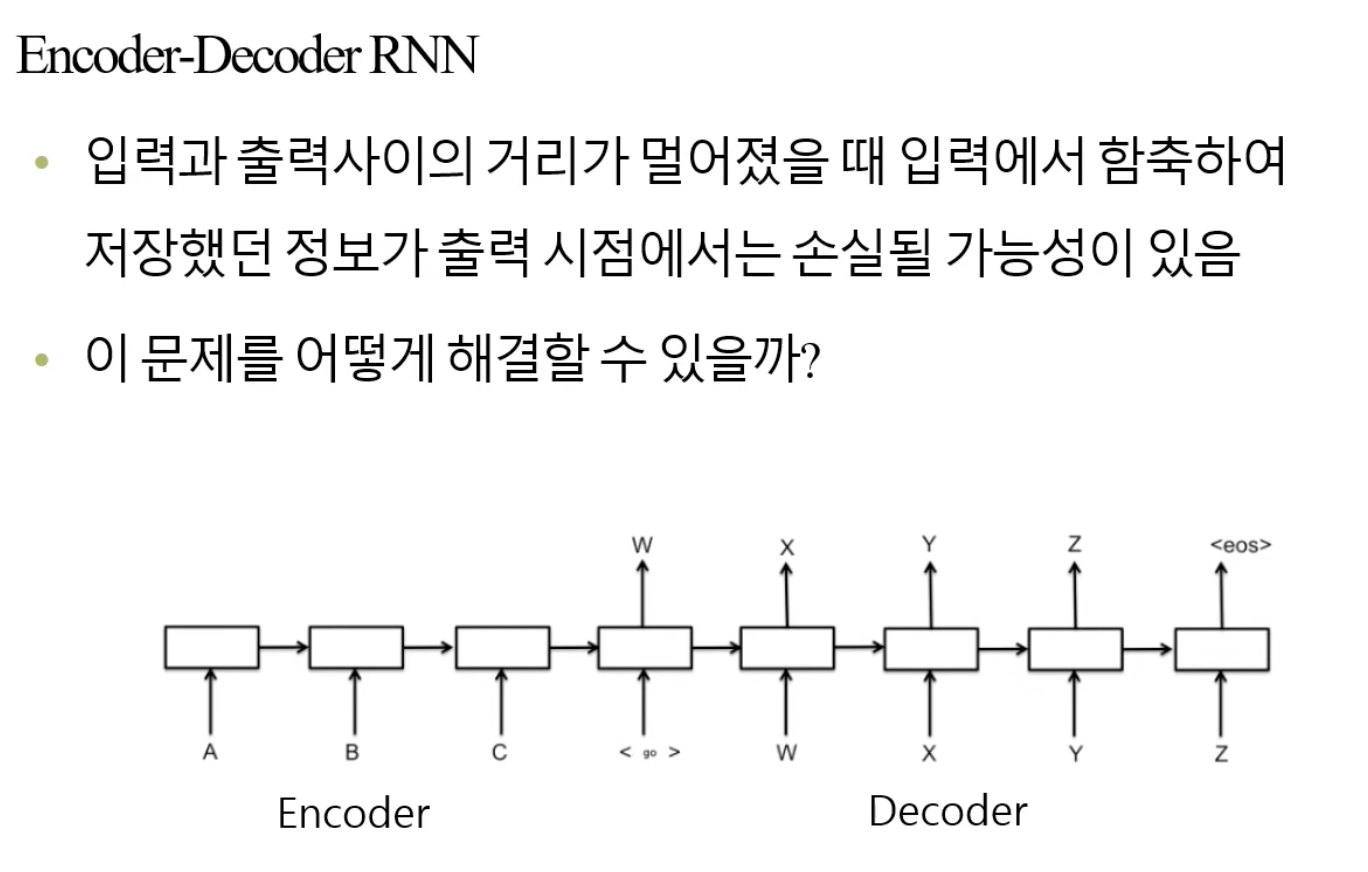

🧑🏻💻용어 정리 Neural Networks Recurrent Neural Network LSTM Attention 지난 시간에 RNN에 이어 LSTM까지 살펴보았습니다. 이번에는 NLP를 현재 엄청나게 핫하게 해준 Attention에 대해 살펴보겠습니다. Attention Mechanism 이 Attention 개념을 통해서 우선, 우리가 주목하지 않았던 것들에 대해서 주목하기 시작한다는 것입니다. 이것은 결국 잃어버렸던 것에 대해서 주목을 하겠다는 것입니다. 이것은 Long-term Dependency에 대한 문제로 돌아옵니다. CNN에서의 depth처럼 RNN에서의 Sequence가 길어졌을 때 발생하는 문제는 비슷합니다. 이 문제를 해결하는 Algorithm이 필요합니다. 이를테면, Decode..