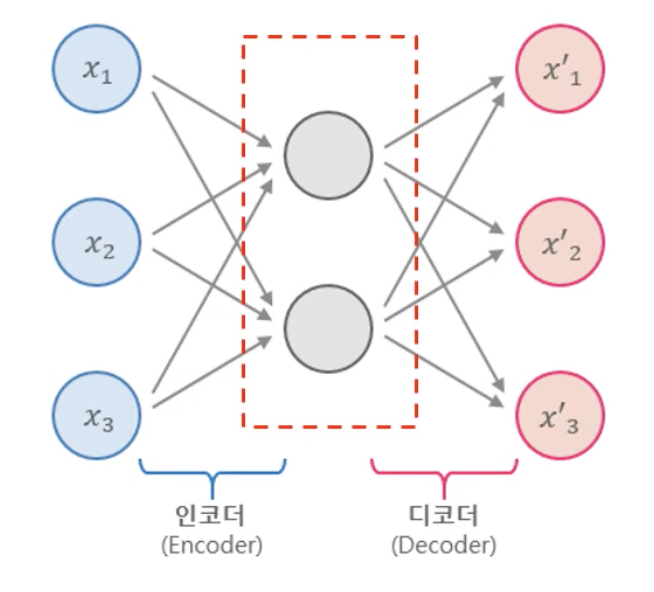

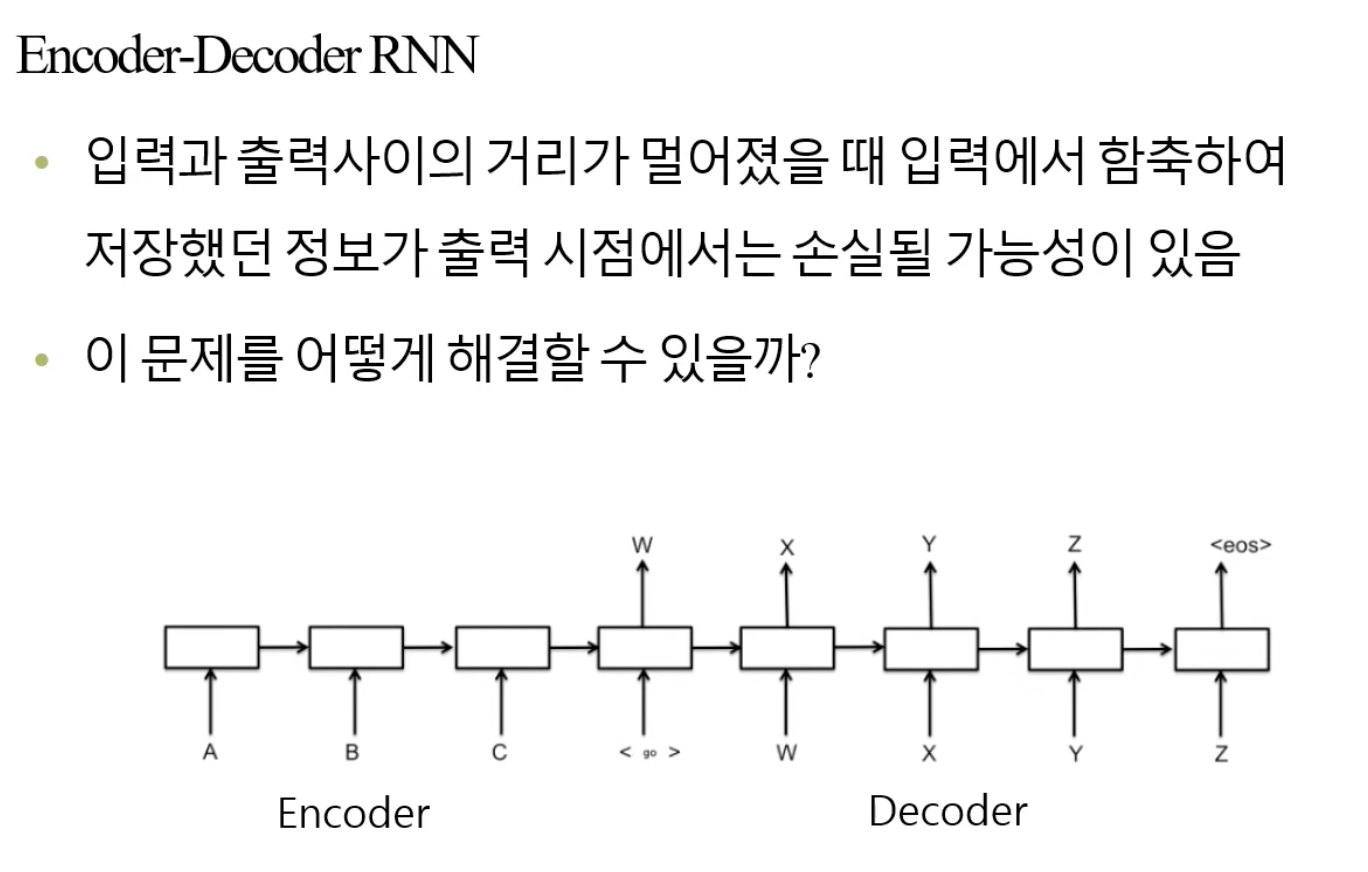

🧑🏻💻용어 정리 Neural Networks Encoder Decoder Autoencoders feature dropout novelty CNN stacked denoising DAE CAE VAE input이 들어오는 것은 neural network 뿐 아니라 다른 Model도 마찬가지로, 어떻게든 connection을 엮어서, 이 connection은 벡터 연산으로 matmul이죠. 이것들을 여러 Layer로 엮어서 우리가 원하는 output을 뽑아내는 것이 우리의 목적입니다. Autoencoders Autoencoders는 똑같이 이런 concept을 이용하면서, 목적에 맞게 모델의 design을 살짝 바꾸며 다른 task에 대한 접근이 가능하게 합니다. Autoencoders는 아래와 같이 생..